1. キャラの顔、毎回違って困るんだけど?

AIで画像を生成してると、目の色や髪型、服のデザインが毎回微妙に変わってしまうことってよくありますよね。特に動画になると「この子、誰だったっけ?」と感じてしまう瞬間が生まれがち。一貫性があると、視聴者の没入感もグッと上がります。

2. Midjourney編:キャラクターリファレンスとオムニリファレンスでキャラ覚えてもらおう

Midjourneyでは、キャラクターの画像を参照できる「キャラクターリファレンス(cref)」や「オムニリファレンス(omniref)」という機能があります。

- キャラクターリファレンス(cref)

- 1枚の参照画像でキャラを固定。Midjourney v6やnijijourney niji6で使用可能。

- オムニリファレンス(omniref)

- 複数枚の画像をまとめて参照。Midjourney v7専用機能。

使用したいキャラクターの正面の顔、全身、後ろ姿が描かれたキャラクターシートを指定します。 プロンプトにもキャラクターの外見情報を記載するとより一貫性のあるキャラクター画像を生成しやすくなります。

3. Stable Diffusion編:LoRAでキャラクターを"記憶"させる

もっと深くキャラを固定したいときに活躍するのが、Stable Diffusionで使える「LoRA(ローラ)」という仕組みです。簡単に言えば、AIにキャラの特徴を“学習”させて、何度描いても同じ子が出てくるようにする方法です。

画像を30〜50枚ほど用意して、専用ツールでタグをつけたり調整したりしてから学習。少し手間はかかりますが、長編や複数作品にキャラを登場させたいときにとても便利です。

「この子はこういう髪型で、こんな服を着てて、表情はこんな感じ…」と細かく覚えてもらえる分、他の方法よりもずっと安定感があります。

4. 他の画像生成ツールでも参照機能が使える

最近は、他の画像生成AIも「この子をベースにして」と伝える機能が増えています。

- Flux.1 Kontext Max:画像からキャラの文脈を読み取って反映してくれる

- ChatGPT・Gemini:画像つきプロンプトで世界観共有

- Runway:Gen-4搭載のReferences機能でキャラや背景の一貫性を保つ

ざっくり言うと、どれも「画像を見せて、この雰囲気で作って〜」というお願いができる機能です。ちょっとした調整や、ビジュアルブレの抑止に役立ちます。

5. Vidu編:キャラクター一貫性を保った動画生成

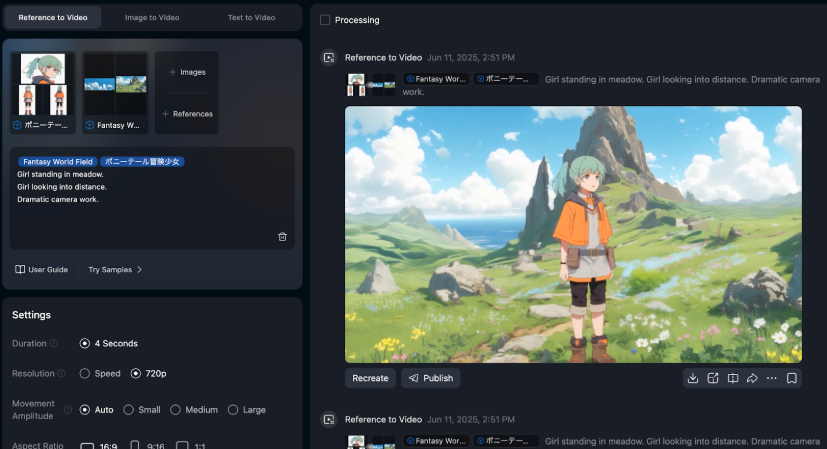

Viduでは、静止画から動画を作るときに使える「Reference to Video」機能があります。

◾️通常のReference

1カットだけの参照に最適

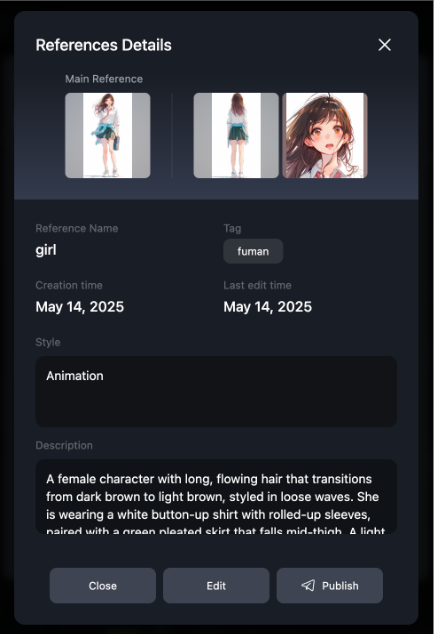

◾️MyReference

複数カットでの一貫性維持に便利。キャラクターの性格や挙動も設定できるため、見た目だけでなく動きや雰囲気の一貫性も表現可能です。

キャラクター、背景、小物などの素材画像を用意するだけで、キャラクターの一貫性を保った動画を手軽に生成できます。 複雑なキーフレーム画像をひとつひとつ作り込む必要がなくなるため、制作のハードルがぐっと下がります。

MyReferences 設定画面

Reference to Video生成画面

6. 他アプローチで一貫性を高める技

AIツールだけに頼らず、画像や動画編集の工夫でもキャラクターの一貫性は高められます。

- 画像編集ソフトでキーフレーム画像を調整

MidjourneyやStable Diffusionで生成したキャラ画像をPhotoshopなどで微修正。複数のキャラクターを1枚のシーンに自然に配置したり、違うツールで作った素材同士を組み合わせる調整も可能になります。

- 動画編集で合成する

Viduで生成したキャラクター映像を、クロマキー合成などで背景に差し込む。映像全体の演出を細かくコントロールできます。

こうしたアナログ的なアプローチを組み合わせることで、より柔軟で完成度の高い映像作品が目指せます。